Quando le AI sono inserite in ambienti fisici o digitali diventano agenti. Ma che ruolo gioca l’ambiente sugli agenti e cos’è l’envelope?

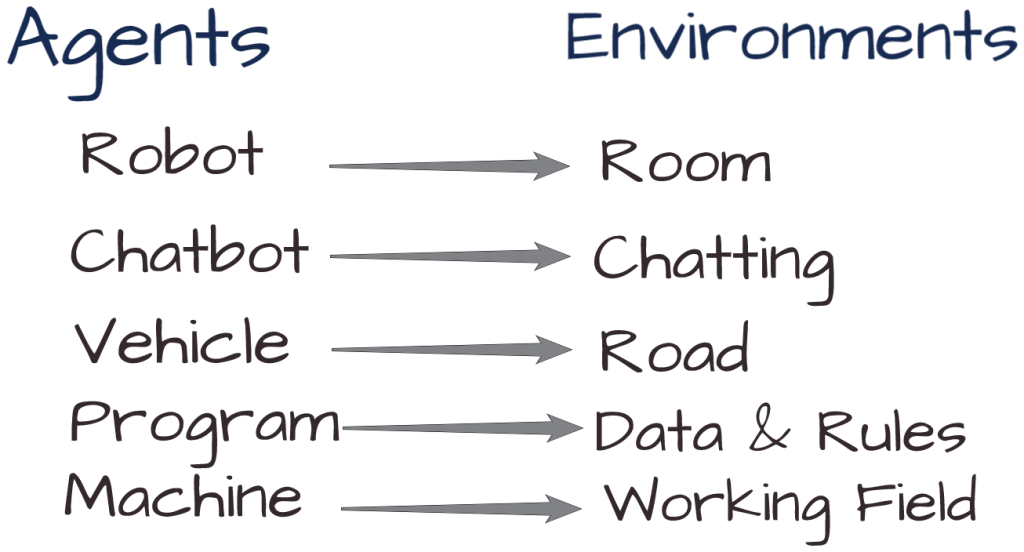

Il decision making dell’Intelligenza Artificiale si basa sull’utilizzo di algoritmi di machine learning, reti neurali e modelli matematici per prendere decisioni in modo automatico, sulla base di dati e informazioni disponibili. I sistemi che prendono le decisioni sono definiti agenti, come accade in qualunque disciplina formalizzata interessata dalle teorie dell’azione (dalle scienze alla logica, dall’epistemologia all’informatica). Russell e Norvig definiscono agente «qualsiasi cosa possa essere vista come un sistema che percepisce il suo ambiente attraverso dei sensori e agisce su di esso mediante attuatori» al fine di raggiungere determinati obiettivi (es. la risoluzione di un puzzle, il riconoscimento dei volti o la rilevazione della luce) tramite azioni specifiche. La percezione (percept) di un agente indica tutti i dati che i suoi sensori ricevono dall’ambiente, mentre la sequenza percettiva (percept sequence) è la storia completa di ciò che l’agente ha percepito nella sua esistenza. Il comportamento dell’agente è descritto in termini matematici e astratti dalla funzione agente, che è implementata concretamente da un programma agente (la sua esecuzione in un sistema fisico).

L’obiettivo fondamentale del campo dell’AI è la realizzazione di agenti razionali (o agenti intelligenti), cioè agenti in grado di fare “la cosa giusta al momento giusto”. Un agente razionale è definito in funzione di percezioni, azioni, obiettivi e ambiente, secondo la cosiddetta descrizione PAGE (Percepts, Actions, Goals, Environment), ed è in genere composto da un software, cioè un algoritmo che guida le sue azioni, istanziato da un’architettura hardware che esegue i calcoli (ad esempio, un computer o un robot). Si dice allora che «per ogni possibile sequenza di percezioni, un agente razionale dovrebbe scegliere un’azione che massimizzi il valore atteso della sua misura di prestazione, date le informazioni fornite dalla sequenza percettiva e da ogni ulteriore conoscenza dell’agente».

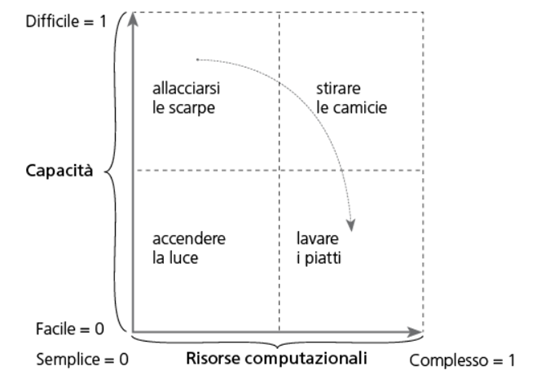

Un agente artificiale basato sulle reti neurali apprende con l’esperienza e agisce generalmente in un ambiente/contesto a informazione incompleta e sulla base di modelli stocastici, statistici e probabilistici, elaborando automaticamente decisioni e azioni a partire da un algoritmo, uno o più dataset (tra cui masse di dati prelevati dai big data) e l’addestramento.Per comprendere gli sviluppi dell’Intelligenza Artificiale in relazione agli ambienti analogici e digitali, Luciano Floridi mappa i problemi in base alle risorse necessarie per risolverli e alla misura in cui l’AI può disporre di tali risorse, secondo la doppia differenziazione di risorse computazionali (gradi di complessità) e risorse relative alle abilità (gradi di difficoltà):

- I gradi di complessità di un problema sono una dimensione altamente quantitativa, la cui trattabilità matematica è dovuta alla disponibilità di criteri standard di confronto chiaramente definiti, come le risorse computazionali di una macchina di Turing. «Se disponiamo di un “metro”, possiamo misurare le lunghezze. Parimenti, se adottiamo una macchina di Turing come punto di partenza, possiamo calcolare quanto tempo, in termini di passaggi, e quanto spazio, in termini di memoria o nastro, “consuma” un problema computazionale per essere risolto».

- I gradi di difficoltà di un problema, in termini di abilità richieste per risolverlo, richiedono «qualcosa di più di una stipulazione per essere mappati, perché di solito la letteratura pertinente, per esempio, sullo sviluppo motorio umano, non si concentra su una tassonomia dei problemi basata sulle risorse necessarie, ma su una tassonomia basata sulla valutazione delle prestazioni degli agenti umani e delle loro capacità o abilità dimostrate nella risoluzione di un problema o nell’esecuzione di un compito. […] In particolare, ci sono molte maniere per valutare una prestazione e quindi svariati modi per catalogare i problemi relativi alle abilità, ma una distinzione standard è tra abilità motorie grossolane e fini. Le abilità grosso-motorie richiedono l’uso di grandi gruppi muscolari, per eseguire attività come camminare o saltare, prendere o calciare una palla. Le abilità motorie fini richiedono l’uso di gruppi muscolari più piccoli, nei polsi, nelle mani, nelle dita, nei piedi e nelle dita dei piedi, per svolgere compiti come lavare i piatti, scrivere, digitare, usare o suonare uno strumento. Nonostante le precedenti difficoltà, possiamo riconoscere immediatamente che abbiamo a che fare con diversi gradi di difficoltà».

Camminare o allacciarsi le scarpe, che per alcuni psicologi come Ericsson e Pool sono forme di expertise e per i neurofenomenologi sono forme di know-how, richiede capacità motorie avanzate ma è un’attività con bassa complessità (facile), ma che richiede un’abilità elevata (difficile). Al contrario, lavare i piatti richiede molti passaggi e molto spazio proporzionalmente ai piatti da lavare, ma non è un compito difficile.

Al fine di ottenere successo con gli agenti artificiali, piuttosto che sviluppare sistemi efficacemente adattivi rispetto agli ambienti umani, abbiamo adattato gli ambienti all’AI. In particolare, affinché agenti fisici come il robot Roomba potessero esprimere un’agency di successo è stato necessario ridurre la complessità dell’ambiente e adeguarlo alle loro deficienze, pena un loro costante fallimento. Insomma, da queste parti l’unica intelligenza pare essere quella naturale, che ha intuito di dover agevolare i sistemi autonomi perché apparissero effettivamente “intelligenti”, utili ed efficaci, piegando l’ambiente alle loro deficienze. Nella complessità dell’ambiente reale, gli agenti tendono ad accumulare insuccessi, anche se l’esperienza li ha resi sempre migliori (si veda il livello raggiunto da armi autonome e guida autonoma). Perché le macchine tornassero utili in certe attività umane, è stato sviluppato il barcode e il QR code, lingue che gli umani non parlano ma che servono ai software per garantire efficienza e lavorare bene; o ancora, per far fronte al problema dei bot e dei malware, sono stati sviluppati i CAPTCHA, codici randomici devono essere riconosciuti e compilati per proseguire le ricerche web e che hanno come finalità la verifica che l’utente è umano e non robot: una sorta di test di Turing al contrario, come osserva lucidamente Floridi.

Istupidire il contesto per far sembrare uno stupido più intelligente, non lo rende davvero intelligente: allo stesso modo, non v’è ancora traccia di agenti veramente intelligenti, ma, nonostante ciò, è inevitabile continuare a costruire gli ambienti secondo le possibilità della tecnologia. Questo processo prende il nome di envelope (avvolgimento), secondo l’espressione di Floridi “enveloping the world”: «Ogni giorno assistiamo all’incremento di potenza di calcolo, di dati, dispositivi (IoT), sensori, tag, satelliti, attuatori, servizi digitali, esseri umani connessi che vivono sempre di più onlife: in una parola, a un maggiore avvolgimento. […] il futuro dell’IA risiede anche in un maggiore avvolgimento, per esempio, in termini di 5G e Internet delle Cose (IoT), e in una crescente dimensione onlife, vale a dire nel fatto che siamo tutti costantemente connessi e trascorriamo sempre più tempo nell’infosfera, mentre tutte le nuove informazioni nascono sempre più digitali».

Se avvolgere significa adattare l’ambiente e le attività alle capacità dell’AI, più sofisticate sono queste capacità, meno necessario è l’envelope: «in un aeroporto, che è un ambiente altamente controllato e perciò più facilmente “avvolgibile”, una navetta potrebbe essere un veicolo autonomo, ma sembra improbabile modificare lo scuolabus di una cittadina, dato che il suo autista deve essere in grado di operare in circostanze estreme e difficili (campagna, neve, nessun segnale, nessuna copertura satellitare ecc.), prendersi cura dei bambini, aprire porte, spostare biciclette ecc., tutte attività che sono più improbabili (attenzione, non logicamente impossibili; su questa distinzione si dirà di più nel decimo capitolo) da avvolgere». Attualmente l’avvolgimento è la migliore soluzione che abbiamo per una buona agency artificiale, ed è una tendenza robusta e cumulativa che si perfeziona progressivamente. In attesa di agenti sufficientemente esperti da svolgere i compiti che noi oggi riteniamo facili, mentre per loro sono difficili, si può solo affermare che i sistemi intelligenti saranno esponenzialmente più utili ed efficaci nella misura in cui gli ambienti saranno sempre più digitalizzati e l’infosfera sempre più estesa.

LEGGI ANCHE: