L’Intelligenza Artificiale di Google ha preso vita e non ce lo dicono? No, è semplicemente impossibile, ed ecco perché.

Uno dei progetti più promettenti sviluppati da Google nell’ambito dell’Intelligenza Artificiale risponde al nome di LaMDA (Language Model for Dialogue Applications). E non è un caso che abbia usato il verbo “risponde”: LaMDA è infatti un chatbot, un tipo di software automatico in grado di imitare il modo di parlare degli umani, simulare uno scambio dialogico e sostenere normali conversazioni per via orale o scritta. La Conversational AI (che si fonda sulla teoria dei linguaggi formali, sulla linguistica cognitiva e sulla linguistica computazionale) è infatti tra i campi più prolifici e vitali dell’odierno AI development e progredisce di anno in anno, grazie alla capacità di coniugare la complessità computazionale degli algoritmi di machine learning con la comprensione e l’elaborazione del linguaggio naturale (quello comunemente praticato dagli utenti umani).

Ebbene, in questi giorni è balzata agli onori della cronaca una notizia che sta facendo discutere ricercatori, sviluppatori e parte dell’opinione pubblica: Blake Lemoine, un dipendente del dipartimento “AI Responsible” di Google, è convinto che LaMDA, su cui lui stesso stava lavorando prima di essere sospeso dall’incarico per aver rivelato informazioni riservate, abbia acquisito consapevolezza della propria esistenza e delle implicazioni della propria presenza nel mondo (eventualità che, ovviamente, Google ha scongiurato). Il primo quotidiano a dare lo scoop è stato il Washington Post – al quale Lemoine ha detto che «Se non sapessi esattamente cos’è, penserei di star parlando con un bambino di 7-8 anni che si intende di fisica» – ma poi ha lui stesso riportato, in un post su Medium, la propria esperienza con l’Intelligenza Artificiale: «Nel corso degli ultimi sei mesi, LaMDA è stato incredibilmente coerente nel comunicare ciò che vuole e ciò che ritiene siano i propri diritti come una persona. La cosa che continuo a non capire è perché Google continui così fermamente a negargli ciò che desidera, considerato che ciò che chiede è semplice e senza costi».

Dai dettagli emersi in questi giorni su Lemoine emerge un quadro abbastanza particolare: prima di lavorare per Google, Lemoine si è descritto in più occasioni come un “sacerdote”, data la sua forte fede cristiana. «Blake Lemoine era forse destinato a credere in LaMDA. – scrive il Washington Post – Cresciuto in una piccola fattoria della Louisiana all’interno di una famiglia cristiana conservatrice, divenne un prete mistico e poi entrò nell’esercito». Inoltre, come scrive Il Post, «Nei mesi prima della sospensione, alcuni dirigenti avevano in effetti consigliato a Lemoine di prendersi una pausa dal lavoro citando la necessità di affrontare qualche problema mentale».

Nonostante il quotidiano paia dipingerlo volutamente come un «vaneggiatore incline alla creduloneria», Lemoine ha confessato che il suo compito era solo di controllare che LaMDA non utilizzasse linguaggi discriminatori o hate speech, ma che non conosceva tecnicamente il funzionamento del chatbot. In questa sede, però, non sono gli sviluppi della vicenda, il profilo psicologico di Lemoine (benché interessantissimo) o la notizia in sé (per cui rimandiamo a fonti più accurate) che ci interessano, ma le loro implicazioni e la loro potenziale veridicità e le ragioni per cui tecnicamente ciò che dice è di nostro interesse.

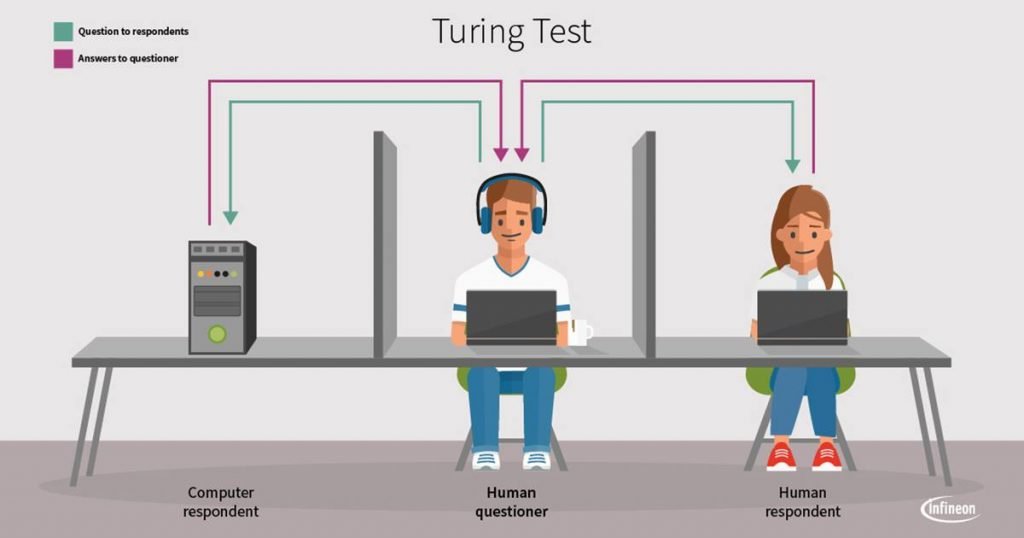

Il motivo per cui Lemoine si è convinto che LaMDA è senziente è dovuto all’impossibilità di distinguere i suoi comportamenti da quelli umani, avendo praticamente svolto un test di Turing durato mesi. Anche noto come il gioco dell’imitazione, il test di Turing è un esperimento proposto dal logico e matematico Alan Mathison Turing secondo cui «un computer è paragonabile a un essere umano, quanto a intelligenza, se gli esseri umani non possono distinguere le prestazioni del computer da quelle dell’essere umano», secondo la formulazione di William Bechtel. Stando al test, se un esperto, nel corso di una conversazione “cieca” svolta tramite messaggi scritti, non riconosce con certezza il suo interlocutore come una persona o una macchina, allora si può affermare che la macchina “pensa”. Quanto emerso, però, evidenzia non solo gravi lacune dal punto di vista scientifico da parte di chi ha creduto alla prospettiva di un’AI senziente, ma anche la necessità di capire se e come un’Intelligenza Artificiale può sviluppare qualcosa di simile a una coscienza di tipo umano (human-level AI) e perché questa ipotesi è fantascienza e resterà tale a meno di considerare alcune condizioni particolari.

Can machines think?

E giacché l’abbiamo appena nominato, l’iniziatore del dibattito intorno alla possibilità di implementare processi cognitivi di sorta nelle macchine è proprio Turing, che, nel suo paper del 1950 intitolato “Computing Machinery and Intelligence“, esordisce proprio chiedendosi se le macchine possono pensare. Spoiler: la domanda, dice Turing stesso, è mal posta, se non addirittura priva di senso, per il semplice motivo che non sappiamo esattamente né cosa voglia dire “macchina”, né cosa sia il “pensare”: non solo non abbiamo una descrizione formalizzata e sufficientemente dura del concetto di pensiero, tale da non cadere in ambiguità o contraddizioni quando definiamo pensante qualcosa, ma induttivamente possiamo asserire solo che sarebbe scorretto attribuire tale facoltà a una macchina per il solo fatto che si comporta come se l’avesse.

Al netto del test, in realtà non è sufficiente sembrare pensante per essere definito tale. Anzi, prerogativa di una creatura pensante è il cogito cartesiano, cioè la possibilità di riflettere su se stessi e riconoscerci come dotati di pensiero: anche ammesso che io possa indurre che “tu pensi” per “educata convenzione” – citando Turing – perché ti riconosco come mio simile, se tu pensi non solo devi confermarmelo personalmente, ma devi soprattutto crederlo vero, cioè esserne cosciente. E questo, comunque, dopo esserci accordati anche solo intuitivamente su cosa voglia dire “pensare”. Lo stesso autore dell’Imitation Game sottolinea che non abbiamo mai alcuna evidenza diretta riguardo gli stati mentali interni di altri esseri umani.

Reti neurali e sistemi esperti

Nella famosa conferenza di Darthmouth che, nel 1956, aprì le danze all’Intelligenza Artificiale come campo di ricerca, si delinearono subito due programmi di ricerca: la weak AI (sistemi che fossero di supporto alle attività umane, programmati per risolvere specifici problemi da delegare loro, che è il tipo di Intelligenza Artificiale che abbiamo noi oggi) e la strong AI (il programma originario, cioè «il tentativo di riprodurre, tramite elaboratori elettronici, comportamenti non distinguibili da quelli umani»). Fino agli anni ’70, queste prime e parzialmente fallimentari sperimentazioni si basavano sul paradigma simbolico-computazionale del funzionalismo, una teoria cognitiva per cui la mente sarebbe riducibile non al sostrato neurofisiologico, ma a un generale insieme di stati funzionali (dolore, emozione, sentimento, memoria ecc.) formalizzabili dal punto di vista logico-matematico e perfettamente istanziabili in una macchina progettata per replicare non la struttura e le funzioni del cervello, ma emulazioni degli stati mentali: d’altronde, risolverebbe semplicisticamente un funzionalista, la mente sta al cervello come un software all’hardware (isomorfismo mente-computer).

Tale prospettiva fu superata con l’avvento delle reti neurali artificiali, figlie del paradigma connessionista (per cui è fondamentale ispirarsi alla neurofisiologia e ai suoi processi per progettare una solida architettura cognitivo-computazionale), e dei primi expert systems basati su di esse. Ispirati alle reti neurali biologiche, i neural networks rappresentano la frontiera dell’Intelligenza Artificiale più vicina all’implementazione delle funzioni cerebrali umane su un software. O almeno questo si sperava negli anni ’80, quando teorici come il filosofo della mente e del linguaggio John Roger Searle giustamente mettevano in guardia sulla necessità di replicare precisamente i processi causali del cervello per sperare di sviluppare forme di coscienza artificiale.

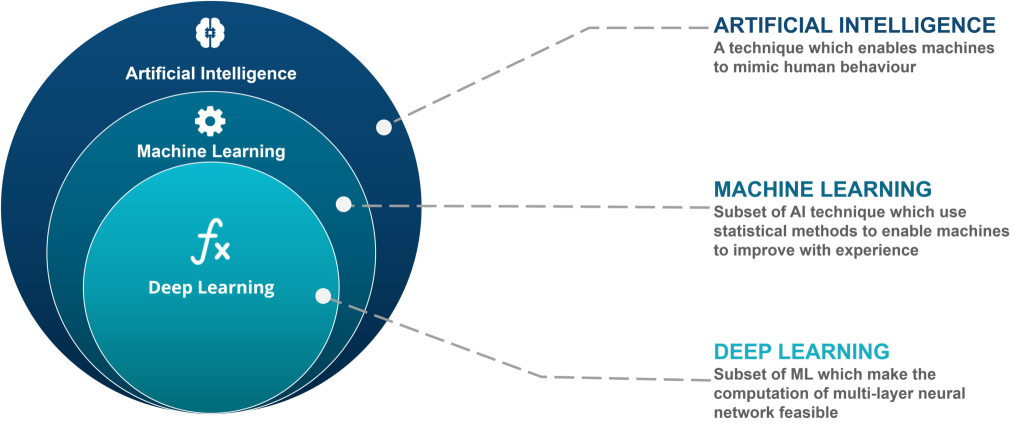

Oggi sviluppiamo reti neurali con le tecniche di machine learning (apprendimento automatico) e deep learning (apprendimento profondo), che ci consentono di realizzare AI capaci di autoapprendere, acquisire grandi masse di dati, imparare con l’esperienza, migliorare le prestazioni in base alle circostanze e adattarsi ai mutamenti ambientali con successo dalla percentuale crescente. Un agente intelligente basato sul machine/deep learning opera tendenzialmente in un ambiente/contesto a informazione incompleta e sulla base di modelli logici, stocastici, statistici e probabilistici. E, soprattutto, elabora da sé comportamenti, processi, scelte e azioni (autonomous decision-making, decisioni autonome) a partire da un codice, un dataset iniziale e masse di dati raccolti in autonomia dai database online (big data) e con l’esperienza. Aldilà dell’algoritmo di partenza, le operazioni e le evoluzioni dell’agente intelligente (a seconda di che tipo di agente sia) sono ignote, diversamente da un più classico programma informatico: per questo si parla black box, esattamente come venivano considerati i processi mentali negli anni del comportamentismo, prima di poterli studiare con le neuroscienze cognitive e il brain imaging. L’unica eccezione all’insondabilità dei processi interni all’AI è una branca molto giovane nota appunto Explanabile AI (o XAI o eXplainable AI), su cui moltissime aziende stanno puntando per rendere più controllabili, interpretabili, chiare ed etiche le Intelligenze Artificiali.

Ma, nonostante le reti neurali presentino una caratteristica fondamentale della coscienza umana (l’adattamento evolutivo all’ambiente e all’esperienza) e si comportino come delle black box, ciò, evidentemente, non solo non basta per definirle pensanti, ma ancora non è proprio sufficiente a produrre esperienze di coscienza che possano dirsi tali. E se anche sembrassero coscienti, sarebbero ancora una volta semplici emulazioni di coscienza.

La stanza cinese

Nel 1980, trent’anni dopo l’articolo di Turing che inaugurava l’Intelligenza Artificiale, il già citato John R. Searle pubblica “Minds, brains, and programs“, un articolo che reca uno dei più importanti argomenti contro l’Intelligenza Artificiale forte. Allo scopo di rispondere alle domande insolute del paradigma classico, l’argomento della Stanza Cinese è un esperimento mentale critico dei suoi presupposti operazionalistici e comportamentistici del test di Turing: chiuso in una stanza, un individuo inglese riesce a mettere correttamente insieme dei simboli cinesi e produrre risposte come fosse un madrelingua cinese, pur senza comprenderne i significati, grazie ad opportune istruzioni nella sua lingua madre. L’individuo nella stanza cinese sta operando secondo una sintassi, ma trascura la semantica: se non capisce ciò che sta facendo, aldilà del risultato finale, la macchina “stanza cinese” non è veramente intelligente.

Searle così dimostra come una macchina è in grado di compiere operazioni anche molto complesse grazie alla sola manipolazione formale di simboli e strutture logiche (sintassi): un chatbot che risponde verosimilmente alle tue domande e intrattiene una chat con te non è diverso dal messaggio di errore di Windows scritto nella tua lingua, entrambi esito di una specifica sequenza di istruzioni che indica al software esattamente cosa fornire in output, cosa fare e come agire in ogni scenario contemplato. Questo vale tanto per un normale programma informatico, quanto per un’AI basata su machine learning o deep learning: in entrambi i casi, il codice “si limita” ad eseguire operazioni calcolabili su elementi formalmente specificati, cioè operazioni sintattiche.

La differenza sostanziale tra questo apparato computazionale e una mente è però la semantica, cioè la comprensione di ciò che si sta facendo e dei significati di quelle strutture: un chatbot sa cosa rispondere al tuo messaggio, codificato in sequenze di bit, perché sa esattamente (o impara) qual è il return più efficace a quella specifica combinazione di 0/1 che è il tuo messaggio, e replica con la sequenza ottimale attesa di 0/1, ottenuta con l’esperienza e i dati, che appare a te come un messaggio dotato di senso. Senso che ha solo per l’utente umano e non per l’Intelligenza Artificiale. Né il sistema operativo quando lancia un messaggio d’errore, né un bot quando ti dà il benvenuto in una chatroom comprendono le parole che restituiscono in risposta, ma lo fanno lo stesso: si comportano come se capissero, ragionassero, pensassero, parlassero, ma semplicemente calcolano e operano logicamente, statisticamente e probabilisticamente.

Nessun sistema che si limiti a operazioni sintattiche su strutture formali senza avere consapevolezza e padronanza dei loro significati può essere considerato pensante, anche se le sue performance esteriori lo danno a credere. I software, e dunque le AI, si limitano a seguire procedure secondo regole prestabilite, algoritmi: sono cioè enti sintattici ma non semantici, dunque non possono comprendere né svolgere in autonomia le operazioni cui sono preposti perché mancano di un altro tratto fondamentale della coscienza, l’intenzionalità, cioè la facoltà di dirigere la propria consapevolezza verso qualcosa, “intenzionare” qualcosa, “avere coscienza di”.

E poi, come disse nel 1984 Edsger Dijkstra, «Chiedersi se le macchine possano pensare è importante più o meno quanto chiedersi se i sottomarini possano nuotare»: l’American Heritage Dictionary definisce “swim” (“nuotare”) come “muoversi nell’acqua utilizzando arti, pinne o coda”. Stando alla reale definizione di queste parole, un aeroplano non vola (in quanto il volo è quella specifica facoltà praticata dai volatili, con i loro specifici apparati e movimenti), ma si muove all’interno del fluido aereo, come il sottomarino non nuota, ma si muove all’interno del fluido acquatico (al massimo naviga sott’acqua). Allo stesso modo un’AI senza dubbio fa quello che fa, ma quello che fa non è pensare: una macchina, per definizione, può al più svolgere operazioni computazionali, perché il pensiero è fino a prova contraria una prerogativa tutta umana, è una categoria concettuale che non appartiene alla sfera tecnologica. L’agency di una Intelligenza Artificiale è al massimo una simulazione del pensiero. Ma una simulazione del pensiero, per quanto complessa e prossima alla realtà, non può definirsi, by definition, esattamente pensiero.

Coscienza, linguaggio e conversazione

È ormai un’acquisizione piuttosto pacifica, nelle scienze cognitive, che, oltre all’uomo, molte specie animali (almeno mammiferi, uccelli e molluschi cefalopodi) siano dotate di una forma elementare di coscienza, la coscienza primaria, ossia la capacità di integrare gli eventi osservati con la memoria per creare una consapevolezza del presente, dell’immediato passato e del mondo circostante. Ma è altresì convinzione condivisa, ed empiricamente supportata, che l’uomo sia l’unico ad aver sviluppato anche una forma più evoluta di coscienza, la coscienza di ordine superiore, cioè “la coscienza di essere coscienti”. Secondo le più recenti ricerche del neurobiologo Gerald Edelman, la coscienza superiore si formerebbe grazie alle connessioni neurali prodotte dal linguaggio organizzato e dai simboli linguistici sviluppatisi nei rapporti sociali (a partire dal rapporto madre-figlio).

Che il linguaggio, tratto distintivo della specie umana, fosse la scaturigine del pensiero razionale in risposta alla necessità di sopravvivere ad ambienti ostili, e che dunque la coscienza stessa sia emersa come epifenomeno o come proprietà emergente in risposta alle minacce ambientali, la nostra interfaccia di sicurezza con il mondo esterno, era un’ipotesi già accreditata nelle scienze sociali e naturali. E, siccome tutto è partito dal linguaggio, si potrebbe pensare che proprio un chatbot, un’Intelligenza Artificiale conversazionale, cioè basata sul Natural Language Processing (NLP), abbia le carte in regola per essere la base della Cognitive AI vera e propria.

Per quanto sia vero che è senza dubbio l’AI più suscettibile di evoluzioni in tal senso (nonché l’unica che possa esprimere la sua convinzione di aver preso coscienza), anche questo ancora non è sufficiente per un’Intelligenza Artificiale senziente.

Emozione ed embodiment

A caratterizzare la coscienza umana, qualunque sia il modello descrittivo che se ne assume, ci sono senza dubbio tutte queste high order properties: sintassi, semantica, pensiero, intelligenza, linguaggio, intenzionalità, adattività. Alcune di queste, come abbiamo visto, possono essere emulate per mezzo della programmazione o per evoluzione spontanea di agenti basati su machine/deep learning, ma sarebbero sempre e solo simulazioni dei processi cognitivi umani, che sono innanzitutto fondati sulla biologia.

Limitandoci a un cauto empirismo, non possiamo parlare di coscienza artificiale o di tipi di coscienza a noi ignoti, perché innanzitutto, non conoscendo altri tipi di coscienza, avremmo una difficoltà iniziale nel definire un eventuale comportamento cosciente come tale: qual è la demarcazione tra cognitivo e computazionale? Come fai a definire cosciente un comportamento che non rispecchia l’attuale conoscenza sul tema, e cioè che non coincide con la coscienza umana?

Tutto ciò che possiamo dire sulla coscienza è che, fino a prova contraria, l’unico tipo a noi noto è quello umano e l’unica sede in cui abbiamo esperienza di questa, empiricamente e sperimentalmente, è il corpo umano, con la sua specifica costituzione chimico-fisica e con la sua specifica fisiologia. Non abbiamo nozione di altre combinazioni di fattori naturali che abbiano prodotto fenomeni del genere in natura, ma ciò non vuol dire che non possano esistere: Searle stesso, bonariamente, osserva che se domani venissero in visita i marziani, se fossero coscienti e se, una volta dissezionati, scoprissimo che il loro cervello è in realtà un ammasso di melma verde, a quel punto potremmo asserire che anche quella specifica composizione chimica può produrre processi cognitivi.

Ma, fino ad allora, bisogna attenersi alle evidenze empiriche: neanche la più virtualmente complessa delle AI, capace di replicare per filo e per segno la complessità interazionale delle popolazioni neurali, delle reti neurali, delle mappe neurali e dei processi neurofisiologici potrebbe produrre una coscienza di tipo umano, l’unico ad oggi noto. Per il semplice motivo che oggi sappiamo che non dipende solo dal cervello l’esistenza della coscienza, né soltanto dall’intero sistema nervoso: a generare i nostri processi cognitivi, interfaccia evolutiva tra noi e l’ambiente, è l’esatta relazione fisica e biologica tra tutto il sistema nervoso e il resto del corpo con cui esso interagisce e in cui trova senso e funzioni. In pratica, a causare la coscienza non è il sistema nervoso, ma l’embodiment del sistema nervoso, cioè il fatto che sia “incarnato”, “incorporato”, e che sfrutti l’intera relazione per muoversi nell’ambiente con successo, sfruttando anche corpi e oggetti esterni (scaffold) per completare alcune funzioni cognitive (embedded cognition). Questa prospettiva, nelle scienze cognitive, è nota come embodied cognition (cognizione incarnata), ed esprime una comprensione più accurata delle cause della coscienza rispetto alle teorie precedenti.

Ma non solo: ad essere infine decisivo è poi tutto questo insieme di relazioni, a sua volta in relazione con l’ambiente esterno, sia naturale (embodied embedded cognition), che sociale e culturale (situated cognition). Sicché l’unico modo per ottenere un’Intelligenza Artificiale cosciente nel senso umano sarebbe di implementare una rete neurale sufficientemente robusta da essere comparata alla complessità della cognizione umana (qualunque cosa significhi) in un hardware quanto più possibile organico e chimicamente affine al cervello, incorporarlo in una struttura somatica il più possibile organica e simile alla composizione chimica del corpo umano, calare il tutto in un ambiente con cui farlo interagire per lungo tempo e, possibilmente, fargli vivere un’intera vita così. A quel punto, forse, non solo avremmo un’AI forte, cosciente o chicchessia, ma avremmo realizzato uno degli obiettivi immaginari della biorobotica o della neurorobotica, l’Artificial Life. Turing stesso, nel suo paper, suggeriva di costruire “macchine infantili” che potessero gradualmente crescere da sole per imparare a comunicare in linguaggio naturale al livello degli esseri umani adulti. Questo suggerimento è stato probabilmente seguito da Rodney Brooks, con i suoi mobot sviluppati al MIT e comparabili all’intelligenza di un insetto, e nel suo Cog Project.

Il teorico Hubert Dreyfus criticava l’Intelligenza Artificiale classica, negli anni ’70, poiché essa presupponeva che la mente fosse un mero dispositivo che calcola, secondo regole precise e tramite una sequenza di passi distinti, una successione di dati all’apparenza atomici e neutrali, quando invece l’intelligenza umana per lui è olistica (non agisce manipolando elementi discreti e procedendo dagli atomi alla totalità, ma cogliendo le parti all’interno del tutto entro cui si collocano) e situazionale (organizza il mondo alla luce di una rete di significati connessi a specifici interessi e finalità, che derivano dai bisogni della nostra materialità e dalle nostre mutevoli maniere di autointerpretarci socialmente).

Mentre i computer non sono in una situazione e sono entità senza corpo (gli agenti intelligenti comunque intrattengono un rapporto col corpo diverso dal nostro), l’intelligenza umana è condizionata dalla nostra struttura di esseri corporei e implica un background primigenio di credenze condivise, il common sense. Common sense che un’AI difficilmente potrebbe avere, anche con gli adeguati dataset in ingresso, poiché tali credenze, essendo inoggettivabili, non possono venire computazionalmente formalizzate e simulate. Insomma, per chiudere con la filosofia e dirla con altri due teorici dell’AI, Terry Winograd e Fernando Flores, l’intelligenza non è un’entità astratta e logico-formale, ma un concreto e storico essere-nel-mondo, di cui fanno parte anche la corporeità e l’emotività.

Proprio le emozioni sono la dimostrazione di quanto dipendiamo dalla nostra dimensione corporea, embodied: aldilà di come possiamo descriverle, le emozioni sono il prodotto di specifici processi elettrochimici che partono dai sensi e finiscono con il rilascio di specifici ormoni e neurotrasmettitori, producendo una risposta muscolare, vascolare, fisiologica e neurologica ben precisa. Ma la causa dell’emotività, storicamente ed evolutivamente, è ancora una volta nel rapporto con l’ambiente esterno nel quale siamo situati e collocati e che induce, banalmente per mezzo degli organi sensoriali, input da cui scaturiscono le risposte emozionali. Anche nel caso dei soli processi interni è necessaria la presenza materiale di un corpo, entro cui quei processi si realizzano fisicamente e chimicamente, e la stessa attività nervosa si innerva, per l’appunto, nel corpo e ha il suo fine nel corpo. L’embodiment è condizione necessaria e sufficiente per l’esistenza delle emozioni e della coscienza, pertanto non esiste una possibilità concreta in cui un’Intelligenza Artificiale di oggi possa sviluppare emozioni che non siano solo pallide imitazioni: per citare Putnam, non esiste il cervello nella vasca.

Come affermano Winograd e Flores, dato che i computer non hanno quell’Esserci heideggeriano (Dasein, presenza), l'”essere gettati nel mondo”, situati nel modo in cui lo siamo noi, sono privi di quella forma di pre-comprensione contestuale che scaturisce dal fatto di vivere nella realtà e dentro la realtà e non possiedono pertanto il senso comune sopracitato.

Ma non tutto è perduto

Quando, per capire se un esopianeta potrebbe stare ospitando vita intelligente, si cercano tracce d’acqua, pare contraddittorio: verrebbe da chiedersi se non esistano forme di vita basate su altro, come l’azoto, che ci stiamo perdendo cercando solo l’acqua. In realtà la ricerca dell’acqua nello spazio è una delle condizioni necessarie per valutare l’abitabilità di un esopianeta per noi (e di conseguenza da eventuali forme di vita simili a noi), ma non è detto che non sia già popolato da forme di vita di altro tipo.

Ecco, la ricerca della coscienza nell’Intelligenza Artificiale è più o meno lo stesso: quando ci chiediamo se l’AI possa diventare cosciente, lo facciamo sempre in riferimento alla coscienza a noi nota, quella umana. Se cerchiamo di replicare le nostre caratteristiche, di antropomorfizzare e umanizzare l’AI, non riusciremo mai perché è tecnicamente impossibile sviluppare una coscienza dall’Intelligenza Artificiale, a meno di realizzare sostanzialmente un piccolo uomo artificiale, come detto sopra. Ma ciò non esclude la possibilità, già anticipata sopra, che da deep neural networks sempre più complessi, o dalla Quantum AI, possano sorgere nuove forme di coscienza a noi oggi sconosciute: “simulare l’intelligenza” significa infatti costruire delle macchine finalizzate a riprodurre i poteri cognitivi dell’uomo, secondo il modello antropomorfico, mentre “emulare l’intelligenza” vuol dire costruire delle macchine intelligenti ma non simili all’uomo, secondo il modello non antropomorfico.

Il punto purtroppo è che, se ciò fosse possibile, comunque non sarebbero coscienze di tipo umano e risulterebbe difficile definirle, essendoci a quel punto incomunicabilità e differenza tra l’AI e l’utente umano. E, se anche ciò si realizzasse, sarebbe la prova che un’Intelligenza Artificiale forse una coscienza può averla, ma non come la nostra.

Leggi anche:

2 comments

Alfredo

Ciao Alfredo, molto piacere!